Die Ausbreitung der künstlichen Intelligenz (KI) wird zu einer massiv steigenden Nachfrage nach mehr Rechenleistung und Speicherkapazität aus der Cloud führen. »KI betrifft alle Bereiche der Informationstechnologie und kann nur erfolgreich genutzt werden, wenn entsprechende Kapazitäten zur Verfügung stehen. Das ist mit unternehmenseigenen Rechenzentren in der erforderlichen Qualität und dem nötigen Service nur mit hohem finanziellem und personellem Aufwand zu bewältigen. Die notwendige Rechenleistung kann nur durch die Cloud flächendeckend gewährleistet werden«, sagt Marcus Busch, Geschäftsführer der Leaseweb Deutschland GmbH.

Grundlage für die Nutzung künstlicher Intelligenz sind Daten. Allein die aktuellen Trends der Automotive-Industrie – allen voran autonomes Fahren – oder die massiven Umbrüche im Banken- und Payment-Sektor beschleunigen das Anwachsen der Datenmenge. Deep-Learning-Systeme können aus diesen Daten wertvolle Erkenntnisse ziehen. Täglich fallen weltweit laut MerlinOne, einem US-amerikanischen Anbieter für Digital-Management-Software, rund 2,5 Trillionen Bytes Datenvolumen an. Diese Menge ist nur dann erfolgreich für KI nutzbar, wenn die Rechenleistung von Clouddienstleistern zur Verfügung steht. Der Datenverkehr wird weiter wachsen und in die Cloud wandern, so der Netzwerkspezialist Cisco. »Im Jahr 2021 prognostiziert Cisco eine Datenmenge von 19,5 Zettabyte im weltweiten Cloud-Rechenzentrumsverkehr. Die Datenmenge wird in den kommenden Jahren exponentiell wachsen. Das beobachten wir auch bei unseren eigenen, weltweiten Rechenzentren, die wir permanent ausbauen, um mit dem steigenden Volumen und dem Qualitätsanspruch unserer Kunden Schritt zu halten«, sagt Leaseweb-Geschäftsführer Busch.

Drastisch steigende Nachfrage nach und Cloud

Aus diesen Gründen erwartet Marcus Busch eine drastisch steigende Nachfrage nach Hosting- und Cloudservices, die auch den Ansprüchen großer Unternehmen und Organisationen gerecht werden. »Der Datenzuwachs macht externe, qualitative Ressourcen unabdingbar, um Zukunftstechnologien gewinnbringend einsetzen zu können. Vor diesem Hintergrund sind Unternehmen gut beraten, sich heute bereits nach einem verlässlichen Hosting- und Cloudanbieter umzusehen. Nur wer auf Hosting-Partner setzt, die die nötige Skalierbarkeit, Flexibilität sowie individuellen Service und Support mitbringen, wird die anfallenden Daten auch effizient nutzen können und sich so wertvolle Wettbewerbsvorteile im internationalen Vergleich sichern.« Der Anspruch an die Infrastruktur wird sich dabei jährlich weiter steigern: »Künftige IT-Infrastruktur muss agil und dynamisch jederzeit den Ansprüchen der Nutzer voraus sein. Das ist mit einer statischen Infrastruktur im Unternehmen nicht abbildbar. Die Qualität von Unternehmen wird mehr und mehr an ihrer digitalen Leistungsfähigkeit gemessen werden, und die wird durch externe Cloud- und Hosting-Spezialisten gewährleistet«, so Marcus Busch von Leaseweb.

Fünf Tipps für sichere Cloud-Nutzung

Ab in die Cloud? Aber sicher!

Die Cloud-Technologie hat in den vergangenen Jahren nicht nur den IT-Markt, sondern auch die Geschäfts- und Arbeitswelt stark verändert. Im Zuge der Digitalisierung und Vernetzung von Geschäftsprozessen hat die Datensicherheit außerdem eine neue Bedeutung erlangt. Diese Relevanz hat auch der Gesetzgeber erkannt und ergänzend zu bestehenden branchenspezifischen Vorgaben mit der DSGVO ein Instrument geschaffen, das die Durchsetzung des Datenschutzes auch in der digitalen Welt auf breiter Ebene ermöglicht. Mit dieser Entwicklung sind die Auswirkungen von IT-Sicherheitsvorfällen nun deutlich unmittelbarer wirtschaftlich spürbar, da mit Datensicherheitsverstößen Haftungsfragen einhergehen und das Vertrauen der Kunden Schaden nehmen kann. Mit großer Skepsis wird angesichts komplexer Anforderungen in vielen Unternehmen daher der Umzug in die Cloud betrachtet. Dabei sind Daten in der Cloud prinzipiell überaus sicher. Risiken für Datenverluste oder Sicherheitsvorfälle entstehen hingegen dadurch, wie die Cloud genutzt wird. Theoretisch können bereits kleine Unachtsamkeiten der Nutzer massive Datenverluste nach sich ziehen – die darüber hinaus womöglich nicht sofort vom Unternehmen entdeckt werden können. Verschärft wird dieses Risiko dadurch, dass Cyberkriminelle dies erkannt haben und ihre Angriffstaktiken auf Schwachstellen in der Nutzung erweitert haben.

Die Herausforderung für Unternehmen besteht also darin, einerseits die gesetzlichen Anforderungen an den Datenschutz zu erfüllen und außerdem sicherzustellen, dass die Nutzung der Cloud möglichst sicher erfolgt. Zwar bringt jedes Unternehmen in dieser Hinsicht individuelle Voraussetzungen mit, doch im Allgemeinen sind die folgenden fünf Aspekte ein geeigneter Ausgangspunkt:

- Eng mit dem Cloud-Provider zusammenarbeiten

Was die Datensicherheit anbelangt, besteht in der Cloud eine geteilte Verantwortung zwischen Anbieter und Nutzer. Wobei der letztgenannte in der Lage sein muss, nachzuweisen, dass er bei der Auswahl des Anbieters größte Sorgfalt hat walten lassen. Dafür sollte zu Beginn Klarheit darüber bestehen, für welche Datenarten Cloudanwendungen genutzt werden sollen. Sind auch personenbezogene Daten betroffen, muss im Sinne der DSGVO geklärt werden, ob die Daten ausschließlich innerhalb des EU-Raums verarbeitet, gespeichert und gesichert werden. Ebenso sollten Nutzer sich vergewissern, dass ihr Anbieter über einen geeigneten Malware-Schutz und ausreichende Wiederherstellungsmechanismen verfügt. Falls der Anbieter mit Subunternehmen zusammenarbeitet, sollte vertraglich festgehalten werden, dass alle Vereinbarungen auch für diese gelten.

Wichtig für Nutzer ist es darüber hinaus, gemeinsam eine Verfahrensregelung bei Sicherheitsvorfällen zu treffen und die internen Prozesse entsprechend anzupassen, damit die gesetzlich geltenden Meldefristen eingehalten werden können.

- Intelligenten Malware-Schutz einsetzen

Mit ihren vielfältigen Sharing-Möglichkeiten bergen Cloudanwendungen ein hohes Risiko für die Verbreitung von Malware, beispielsweise durch infizierte Dokumente. Mit dem enormen Aufkommen an Daten und der Schnelligkeit des Austauschs sind signaturbasierte Antivirenlösungen längst überholt. Mit automatisierten Sicherheitslösungen, die in Echtzeit alle Dateien in der Cloud auf Malware überprüfen, kann ein geeignetes Schutzniveau erzielt werden. Idealerweise sollten diese über Machine Learning-Funktionen verfügen, mit denen anhand verhaltensbasierter Analysen auch bislang noch unbekannte Bedrohungen als verdächtig gekennzeichnet und entsprechend eingedämmt werden können.

Dieser Schutz sollte nicht ausschließlich auf die Cloud beschränkt bleiben. Denn die Endpoints, die auf diese Dateien zugreifen, stellen ebenfalls ein Risiko dar. Auch dort sollte es möglich sein, potenziell gefährliche Daten vor ihrem Weg in die Cloud herausfiltern zu können. Der Cloud-Malware-Schutz sollte daher mit den Endpoint-Security-Tools kompatibel oder in einer Lösung enthalten sein.

- Identitäts- und Zugriffsmanagement implementieren

Die Unternehmens-IT ist nicht mehr ausschließlich auf den Firmenstandort beschränkt. Prinzipiell können Mitarbeiter und mitunter auch externe Auftragsnehmer von überall über ihre Accounts auf die Clouddaten zugreifen. Allein die Zugangsdaten bieten dafür keinen geeigneten Schutz. Mit Identity and Access Management (IAM) kann durch Einbeziehung kontextabhängiger Faktoren das Sicherheitsniveau erhöht werden. Beispielsweise können Richtlinien erstellt werden, in denen definiert wird, dass der Zugriff aus bestimmten Ländern oder über ungesichertes WLAN verweigert wird. Darüber hinaus können die Zugriffsrechte je nach Abteilung, Position, Dokumentenarten, Standort, Endgerät oder Zeiträume verfeinert werden.

- Datenverschlüsselung und DLP nutzen

Ergänzend zu der Eliminierung von umgebungsbedingten Risiken spielt der unmittelbare Schutz der Daten in der Cloud eine zentrale Rolle. Durch eine Verschlüsselung nach höchstem Standard ist dafür gesorgt, dass Daten bei Verlust für Dritte unbrauchbar sind. Mit zusätzlichen Data Loss Prevention (DLP)-Funktionen erhält die IT-Abteilung einen anwendungsübergreifenden Überblick aller Datenströme, der damit verbundenen Benutzeraktivitäten und ist in der Lage, bei Bedarf kontrollierend einzugreifen.

- Unternehmensangehörige schulen

In der vernetzten Welt können auch Personen eine Schwachstelle für IT-Umgebungen darstellen. Hacker setzen mittlerweile in hohem Maße auf Social-Engineering-Angriffstaktiken, da diese in der Regel erfolgreicher sind. Mit regelmäßigen Schulungen über aktuelle Betrugsversuche sowie der Möglichkeit, verdächtige Ereignisse mit geringem Aufwand melden zu können, können Mitarbeiter für ihre wichtige Rolle sensibilisiert und in die IT-Verteidigungsstrategie integriert werden.

Datensicherheit in den Fokus rücken

Die Notwendigkeit all dieser Sicherheitsmaßnahmen auf verschiedenen Ebenen zeigen auch auf, wie die Anforderungen der Datensicherheit und die Besonderheiten der Cloud-Technologie zusammenwirken. Unternehmen müssen dafür Sorge tragen, dass die von ihnen verarbeiteten Daten stets sicher sind – und dies beschränkt sich nicht auf den Cloud-Speicherort, sondern schließt potenzielle Risiken für Datenverluste, die durch die Nutzung der Cloud entstehen könnten, mit ein. Ergänzend zum traditionellen Schutz des eigenen Netzwerks müssen Unternehmen auch alle Übertragungswege in die Cloud sichern. Ein lückenloser Schutz kann am besten erzielt werden, wenn ausgehend von den Daten und ihren Verarbeitungswegen geeignete Sicherheitsmaßnahmen entwickelt werden.

Michael Scheffler, Regional Director Central and Eastern Europe, Bitglass

189 Artikel zu „Hosting Cloud“

Hosting und Managed Infrastructure Services behaupten sich neben Cloud Services

Infrastructure Services sind trotz der zunehmenden Bedeutung von Cloud Services noch immer ein wesentlicher Pfeiler des IT-Marktes. Die wenigsten Unternehmen sehen es heute noch als zielführend an, eigene Rechenzentren zu bauen, zu unterhalten und auf einem angemessenen Standard zu halten. Gleichzeitig macht eine zunehmende Ressourcenknappheit im Bereich der qualifizierten Administratoren einen Eigenbetrieb schwierig. Entsprechend wächst…

TRENDS WIRTSCHAFT | BUSINESS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | OUTSOURCING| RECHENZENTRUM | SERVICES | STRATEGIEN

Cloud- und Hosting-Markt: Abkehr vom Hosting, hin zu IaaS

Immer mehr europäische Unternehmen nutzen Cloud Computing [1]. Im Rahmen der »2014 European Hosting and Cloud Survey« wurden über 400 Führungskräfte und IT-Entscheider aus der Hosting- und Cloud-Branche befragt. Die Ergebnisse zeigen deutlich, dass sich der Markt in einer Umbruchphase befindet: Zahlreiche Unternehmen stellen auf die Cloud um und beziehen vor allem Infrastructure as a…

TRENDS SECURITY | NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | IT-SECURITY

Cloud: Welche Hintertüren offen sind

Ob File-Sharing, Zugriff von privaten Geräten oder Shadow-IT: Das sind die Schwachstellen in Cloud-Infrastrukturen. Daten liegen nicht nur in der Cloud – mit Daten wird gearbeitet. Genau das ist der Punkt, der IT-Verantwortliche weltweit immer noch vor Herausforderungen stellt: Nur ein Drittel (33 Prozent) kann beispielsweise für ausreichend Sicherheit sorgen, wenn Mitarbeiter Links zu Dateien…

AUSGABE 5-6-2019 | CLOUD COMPUTING | FAVORITEN DER REDAKTION | SERVICES

Cloud flavoured IT – der Trend, wie Unternehmen die Cloud nutzen

Die Cloud hilft dabei unterschiedlichste Aufgaben einfacher, besser, kostengünstiger oder effizienter zu gestalten. Nahezu alle Unternehmen werden einem hybriden Cloud-Service-Konzept folgen. Dem hybriden Cloud-Modell gehört die Zukunft.

NEWS | CLOUD COMPUTING | EFFIZIENZ | FAVORITEN DER REDAKTION | INFRASTRUKTUR | OUTSOURCING | RECHENZENTRUM | SERVICES

Cloud-Repatriation – Warum migrieren Unternehmen aus der Public Cloud zurück?

Unternehmen nutzen vermehrt die Hybrid Cloud um Daten und Anwendungen in alle Umgebungen verschieben zu können. Dies macht das Zurückholen von Daten und Anwendungen ins eigene Rechenzentrum offiziell zu einem Trend. Noch vor wenigen Jahren glaubten wir, dass die Public Cloud die Zukunft der IT ist und früher oder später, physische Rechenzentren ersetzen würde.…

NEWS | CLOUD COMPUTING | IT-SECURITY | TIPPS

Drei Tipps zur Absicherung von Public-Cloud-Ressourcen

Immer häufiger erhalten Hacker Zugriff auf die Public-Cloud-Ressourcen von Unternehmen und Organisationen. Die Ursache ist oft ein nachlässiger Umgang mit den Zugangsschlüsseln berechtigter Nutzer. Eine wesentliche Quelle solcher Schlüssel stellen Entwickler-Plattformen wie GitHub dar, auf denen Mitglieder der DevOps-Teams oft auch vertrauliche Informationen ablegen, die sich in Skripten oder Konfigurationsdateien befinden. Hacker sind sich dessen…

NEWS | CLOUD COMPUTING | FAVORITEN DER REDAKTION | IT-SECURITY | RECHENZENTRUM | TIPPS

Cloud Security: Sechs Maßnahmen für effektive Cloud-Sicherheit

Sicherheitsverantwortung in der Cloud durch Shared-Responsibility-Modell: Unternehmen tragen als Kunden Eigenverantwortung für kritische Bereiche. Die zunehmende Nutzung von Public-Cloud-Ressourcen macht es erforderlich, dass Unternehmen ihre Sicherheitsverantwortung ernster nehmen. Basierend auf dem Modell der geteilten Sicherheitsverantwortung von Anbieter und Kunde ergeben sich einige entscheidende Anforderungen an zuverlässige Cloud-Sicherheit. Sechs grundlegende Maßnahmen für effektive Cloud-Sicherheit helfen das…

NEWS | CLOUD COMPUTING | IT-SECURITY | RECHENZENTRUM | TIPPS

Sicherheit in der Cloud: Herausforderungen bei Cloud-First-Strategie bewältigen

Die heutige vernetzte Welt basiert auf der Datenzugänglichkeit von überall, zu jeder Zeit und auf jedem Gerät. Die Geschwindigkeit und Agilität, die mit Hosting-Diensten und -Anwendungen in der Cloud einhergeht, sind für den Erfolg zentral. Die damit verbundenen Vorteile haben Unternehmen in den letzten Jahren gezwungen, zumindest einige und in manchen Fällen sogar alle ihre…

NEWS | CLOUD COMPUTING | DIGITALISIERUNG | DIGITALE TRANSFORMATION | AUSGABE 3-4-2019

Digitalisierung und Cloud-Strategie – Die digitale Transformation im Kontext des Multi-Cloud- Hypes

Ohne Nutzung von Cloud-Services ist die digitale Transformation ein Ding der Unmöglichkeit. Bei der Auswahl des Cloud-Angebots hat das auslagernde Unternehmen die Qual der Wahl. Entscheidend für den Erfolg der digitalen Transformation ist die richtige Cloud-Strategie.

VERANSTALTUNGEN

Experten diskutieren über die Zukunft der Cloud

Vom 23. bis 29. März 2019 dreht sich beim CloudFest im Europapark Rust alles um die Zukunft der Cloud- und Hosting-Branche. Das CloudFest zählt zu den wichtigsten Veranstaltungen für Cloud-Technologien und -Strategien in Deutschland. Mit über 7 000 Besucher erwarten die Veranstalter in diesem Jahr wieder eine neue Rekordmarke. Die IT-Spezialisten der noris network AG…

NEWS | CLOUD COMPUTING | DIGITALE TRANSFORMATION | EFFIZIENZ | LÖSUNGEN | OUTSOURCING | PRODUKTMELDUNG

Hybride Multi-Cloud-Lösungen für mehr Freiheit und Transparenz

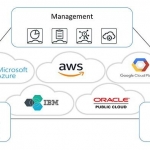

Sollten sich Unternehmen mit einem »Eine-Cloud-für-alles«-Ansatz begnügen? Nein! Denn Unternehmen, die offene, hybride Cloud-Lösungen nutzen, haben ganz klare Wettbewerbsvorteile. Denn eine hybride Multi-Cloud-Architektur passt sich mit verschiedenen Cloud-Anbietern und Konfigurationen ideal an unterschiedliche Use-Cases an und lässt sich trotzdem einheitlich verwalten. Mythen über Multi-Clouds Es ist ein verbreitetes Missverständnis, dass mehrere Clouds automatisch eine…

TRENDS 2019 | NEWS | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | TRENDS SERVICES | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

C3 – Cloud, Connectivity und Colocation

Drei Zauberworte für die digitale Infrastruktur deutscher Unternehmen. Eine neue Studie von 451 Research im Auftrag von Digital Realty hat die Herausforderungen untersucht, mit denen sich deutsche Unternehmen beim Auf- und Ausbau ihrer digitalen Infrastrukturen konfrontiert sehen [1]. Dabei spielen nicht nur die Verwaltung der eigenen IT, sondern auch der Zugriff auf andere Dienstleistungen…

Korte Noack,

Korte Noack,

a Stiehl,

a Stiehl,