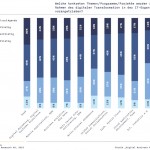

Die weltweit leistungsfähigsten Rechnersysteme werden als Supercomputer bezeichnet. Die meisten dieser digitalen Giganten finden ihren Einsatz in der Industrie. Hier berechnen sie u.a. komplexe Simulationen. Die Infografik zeigt die Rechenleistung der leistungsstärksten Supercomputer weltweit im November 2018. Der Rechner »Summit« vom Hersteller IBM erzielt eine Leistung von rund 143.500 TeraFLOPS (21,23 Billiarden FLOPS). FLOPS steht dabei für Floating Point Operations Per Second und bezeichnet die Anzahl der ausführbaren (Gleitkomma-) Rechenoperationen pro Sekunde. Zum Vergleich: laut Angaben von Sony erreicht die Grafikeinheit der Spielekonsole Playstation 4 eine Rechenleistung von 1,84 TeraFLOPS. Umgerechnet in Konsolen entspricht die Leistung von Summit also der von rund 78.000 Sony Playstation 4.

Als schnellstes deutsches Rechensystem ist der Rechner SuperMUC-NG erstmals unter die in der Grafik gezeigten weltweiten Top-10 eingezogen. Der deutsche Superrechner vom Hersteller Lenovo hat es dabei knapp verpasst, sich an die europäische Spitze zu setzen: Vor ihm liegt noch Piz Daint aus der Schweiz.

Die im Halbjahres-Rhythmus veröffentlichte Top-500-Liste der rechenstärksten Computer ist ein Indikator dafür, wo Forschung mit Big Data am intensivsten betrieben wird. Die meisten dieser Rechner stehen in China. Matthias Janson

https://de.statista.com/infografik/16589/rechenleistung-der-leistungsstaerksten-computer-weltweit/

4 search results for „Supercomputer“

NEWS | TRENDS WIRTSCHAFT | BUSINESS | BUSINESS INTELLIGENCE | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | INFRASTRUKTUR | TRENDS 2017

Die Top-500-Liste der Supercomputer

Die aktuelle Top-500-Liste der weltweit leistungsfähigsten Supercomputer hat ein Jubiläum: In dieser Woche erschien die 50. Ausgabe. Seit 25 Jahren werden nun die Leistungen der Supercomputer am Linpack-Benchmark gemessen, und seit einigen Jahren gibt es auch eine Liste für die energieeffizientesten Höchstleistungscomputer, die Green-500-Liste. China legt zu und überholt die USA Es ist schwieriger geworden,…

NEWS | TRENDS WIRTSCHAFT | TRENDS INFRASTRUKTUR | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | TRENDS 2017 | RECHENZENTRUM

Die Top 10 der Supercomputer

Lenovo ist eines der – wenn nicht sogar das – führende Unternehmen auf dem weltweiten PC-Markt. Das bedeutet Konzernchef Yang Yuanqing indes nur wenig. Er plant, den chinesischen Elektronikkonzern künftig ganz auf Supercomputer und Datencenter auszurichten. Die Grundlage für ersteres ist auf jeden Fall bereits da. 85 der aktuell 500 leistungsstärksten Supercomputer weltweit hat Lenovo…

NEWS | TRENDS WIRTSCHAFT | BUSINESS | TRENDS SECURITY | BUSINESS PROCESS MANAGEMENT | DIGITALISIERUNG | EFFIZIENZ | TRENDS 2017 | IT-SECURITY | RECHENZENTRUM | SERVICES | STRATEGIEN

Blockchains: Supercomputer-Leistung für die Sicherheit

Blockchains sind spezielle Datenbanken, die Transaktionsdaten ohne eine zentrale Kontroll-Instanz, ohne die Notwendigkeit gegenseitigen Vertrauens und mit vollkommener Transparenz verwalten können. Die größte und bekannteste öffentliche Blockchain ist die von Bitcoin – sie läuft auf einem Netzwerk von aktuell etwa 5600 Servern im Internet und führt am Tag über 240.000 Transaktionen durch. Das ist in…

NEWS | IT-SECURITY | LÖSUNGEN | PRODUKTMELDUNG | STRATEGIEN

Supercomputer im Kampf gegen Internetkriminalität

Cyber Reconnaissance and Analytics analysiert potenzielle Schwachstellen aus Angreifersicht und ermöglicht so die proaktive Erkennung und effiziente Bekämpfung von Cyberbedrohungen. Deloitte Advisory Cyber Risk Services und der Anbieter von Supercomputern, Cray bringen mit Cyber Reconnaissance and Analytics den ersten kommerziellen Service für die ultraschnelle Bedrohungsanalyse auf Grundlage von Supercomputing-Technologie auf den Markt. Der abonnementbasierte Service…

NEWS | TRENDS CLOUD COMPUTING | CLOUD COMPUTING | INFRASTRUKTUR

Die schnellsten Rechner der Welt: Jülicher Supercomputer weiterhin in den Top 10

Der Jülicher Supercomputer JUQUEEN belegt als schnellster deutscher Rechner den achten Platz auf der TOP500-Liste vom November 2014. Dabei handelt es sich um die halbjährlich aktualisierte Liste der schnellsten Rechner der Welt. JUQUEEN am Jülich Supercomputing Centre (JSC) erzielt mit insgesamt 458.752 Rechenkerne eine Spitzenleistung von 5,9 Petaflops oder, anders ausgedrückt, 5,9 Billiarden Rechenoperationen pro…

NEWS | INFRASTRUKTUR | KÜNSTLICHE INTELLIGENZ

Datenautobahn: Wie Unternehmen Datenschätze heben, die auf der Straße liegen

Die Elektromobilität wird dazu führen, dass Fahrzeuge und Infrastrukturen riesige Datenströme generieren. In dieser Daten-Goldgrube verstecken sich viele Hinweise darauf, wie Unternehmen ihre Angebote und Produkte verbessern, aber auch die Kundenzufriedenheit steigern können. Wer den Datenschatz heben möchte, benötigt eine übergreifende Datenplattform und KI-Lösungen mit Maschine-Learning-Komponenten. In den Medien generiert das Thema Elektromobilität derzeit interessante…

NEWS | TRENDS WIRTSCHAFT | BUSINESS | DIGITALISIERUNG | TRENDS 2018

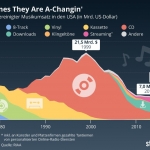

Musikumsatz: The Times They Are A-Changin‘

1999 war ein extrem umsatzstarkes Jahr für die US-Musikindustrie. 21,5 Milliarden US-Dollar wurden damals erwirtschaftet – davon 89 Prozent durch CDs. Gut möglich, dass sie damals in den Chefetagen der Major Labels dachten, dass es genau so weiter gehen würde. Tatsächlich sollte es aber erstmal für mehr als ein Jahrzehnt bergab gehen für die Branche,…

NEWS | PRODUKTMELDUNG

FIPS 140-2-Validierung: Sicherheitszertifikat für RDX-Verschlüsselung

Overland-Tandberg, Spezialist für Datenmanagement-, Backup- und Archivierungslösungen, hat die Hardwareverschlüsselung PowerEncrypt für RDX-Wechselplatten erfolgreich nach dem bedeutenden US-Sicherheitsstandard FIPS 140-2 validieren lassen. Produkte mit der begehrten FIPS 140-2-Validierung gelten als »vertrauliche« Produkte und stehen weltweit als Ausdruck von Datensicherheit und -integrität. In Europa gewährleistet FIPS 140-2 Verschlüsselungsstandards nach EU-DSGVO. Die FIPS 140-2-validierte Verschlüsselung ist…

NEWS | DIGITALISIERUNG | KOMMENTAR | KÜNSTLICHE INTELLIGENZ | ONLINE-ARTIKEL

KI: Revolutionäre Technologie oder alles nur ein Hype?

Aktuell erscheint kaum eine Ausgabe der großen deutschen Tageszeitungen, in der nichts von künstlicher Intelligenz zu lesen ist. Die Bundesregierung will die Erforschung und Entwicklung von AI massiv fördern und fast jedes Unternehmen will davon profitieren. Doch wie soll das genau aussehen? Ist diese Technologie überhaupt marktreif? Welche Kosten sind damit verbunden? Michael Jores, Regional…

NEWS | TRENDS 2019 | DIGITALISIERUNG | EFFIZIENZ | TRENDS SERVICES | KÜNSTLICHE INTELLIGENZ | SERVICES

Künstliche Intelligenz: Die meisten Menschen würden sich nicht von Robotern operieren lassen

61 Prozent der Deutschen würden OP durch menschlichen Chirurgen anstatt Roboter vorziehen. Verbraucher erkennen Potenzial von KI im Gesundheitswesen, geben aber ungern Kontrolle über ihre Daten ab. Laut einer aktuellen Umfrage ziehen 61 Prozent der Deutschen einen menschlichen Chirurgen einem Roboter vor, selbst wenn es den anschließenden Heilungsprozess beschleunigen würde. Betrachtet man alltäglichere Szenarien,…

NEWS | BUSINESS INTELLIGENCE | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | LÖSUNGEN | ONLINE-ARTIKEL | RECHENZENTRUM | SERVICES

Die Entwicklung von Big Data zu Fast Data

Das »Warum« der Datenverarbeitung liegt auf der Hand, wenn man die große Anzahl von Sensoren, vernetzten Geräten, Websites oder mobilen Anwendungen betrachtet; oder einfach alle Daten, die sowohl von Menschen als auch von Maschinen erzeugt werden. Die immensen, rasch ansteigenden Datenberge erfordern kontinuierlich leistungsfähigere Ansätze zur Datenverarbeitung. Open Source spielt dabei nach Meinung der data…

NEWS | TRENDS 2019 | TRENDS SECURITY | DIGITALISIERUNG | IT-SECURITY | RECHENZENTRUM

2019, das Quanten-Jahr? Das nicht, aber das Jahr um sich darauf vorzubereiten

Vor einigen Wochen veröffentlichte die National Academies of Sciences, Engineering and Medicine einen neuen Bericht, in dem sie Fortschritte und Perspektiven – oder deren Fehlen – rund um das Thema Quantencomputer – untersucht hat [1]. Der Report skizziert verschiedene technische und finanzielle Probleme, die es zu überwinden gilt, bevor man einen funktionsfähigen Quantencomputer bauen kann.…

NEWS | TRENDS SECURITY | TRENDS 2018 | IT-SECURITY

480 neue Bedrohungen pro Minute

IoT-Malware steigt um 73 Prozent. Krypto-Malware breitet sich weiter rasant aus. Finanzsektor erlitt 20-prozentigen Anstieg in Datenverlusten. Der neue McAfee Labs Threats Report untersucht die Entwicklungen von Cyberangriffen des dritten Quartals 2018 [1]. Der Report verzeichnet durchschnittlich 480 neue Bedrohungen pro Minute und einen starken Anstieg jener Malware, die auf IoT-Geräte abzielt. Auch Krypto-Mining-Malware…

NEWS | TRENDS 2019 | TRENDS WIRTSCHAFT | BUSINESS | DIGITALISIERUNG | KÜNSTLICHE INTELLIGENZ

Deutsche Verbraucher erhoffen sich durch künstliche Intelligenz bessere Karrierechancen

44 Prozent der Deutschen glauben nicht, dass sie ihren Arbeitsplatz an künstliche Intelligenz verlieren. 38 Prozent erhoffen sich bessere Karrierechancen durch neue Technologien. Laut einer aktuellen Umfrage glauben 44 Prozent der Deutschen nicht, dass sie aufgrund von künstlicher Intelligenz (KI) ihren Arbeitsplatz verlieren, sondern erwarten durch neue Technologien noch interessantere Karrierechancen (38 Prozent). Die…

NEWS | TRENDS 2019 | TRENDS WIRTSCHAFT | TRENDS SECURITY | IT-SECURITY

Blick in die Sicherheits-Kristallkugel für 2019

Der Schutz von Kundendaten sollte an oberster Stelle stehen. Händler müssen grundlegende Sicherheitsmaßnahmen, wie Verschlüsselung an jedem Kontaktpunkt einsetzen, innerhalb der gesamten Lieferkette, am Einkaufsort und am Bestimmungsort. Für Unternehmen ist es unerlässlich, sich auf Kryptographie-Ansätze für das Zeitalter der Quantenrechner und die Post-Quantum-Welt zu vorzubereiten. 2019 könnte der Höhepunkt im Hype-Zyklus um Blockchain…

Christian Leutner,

Christian Leutner,

Seit August 2018 verantwortet Andreas Schürkamp das Consulting der SECUrisk, einen Geschäftsbereich der DATA CENTER GROUP. Zu seinen Aufgaben gehört neben der fachmännischen Beratung auch der weitere Ausbau und die zukunftsorientierte Optimierung des Angebotsportfolios. Vor seiner Tätigkeit bei der DATA CENTER GROUP war er 14 Jahre als Technischer Leiter bei der DTS Systeme tätig und arbeitete an technischen und strategischen IT-Lösungen in den Bereichen Data Center, Technologie und Security.

Seit August 2018 verantwortet Andreas Schürkamp das Consulting der SECUrisk, einen Geschäftsbereich der DATA CENTER GROUP. Zu seinen Aufgaben gehört neben der fachmännischen Beratung auch der weitere Ausbau und die zukunftsorientierte Optimierung des Angebotsportfolios. Vor seiner Tätigkeit bei der DATA CENTER GROUP war er 14 Jahre als Technischer Leiter bei der DTS Systeme tätig und arbeitete an technischen und strategischen IT-Lösungen in den Bereichen Data Center, Technologie und Security.

Mark Muschelknautz

Mark Muschelknautz