Die Entfernung zwischen georedundanten Rechenzentren soll mindestens 200 km betragen. So empfiehlt es das BSI seit diesem Jahr. Dies stellt viele Unternehmen vor Probleme, betrug die bisher empfohlene Distanz in der Vergangenheit doch gerade einmal fünf Kilometer. Diese geringe Distanz erlaubte es den Betreibern bisher, ihre Rechenzentren über HA-Systeme synchron zu spiegeln. Dies ist bei einem Abstand von 200 km jedoch nicht mehr möglich: Die Latenz zwischen den Standorten ist einfach zu hoch, um Organisationen mit traditionellen Hochverfügbarkeits- und Backup-Lösungen gegen Systemausfälle zu schützen. Was können Unternehmen nun tun, um ihre IT etwa gegen logische Fehler oder Ransomware-Attacken abzusichern, um minimalen Datenverlust und kurze Ausfallzeiten zu garantieren?

Die Entfernung zwischen georedundanten Rechenzentren soll mindestens 200 km betragen. So empfiehlt es das BSI seit diesem Jahr. Dies stellt viele Unternehmen vor Probleme, betrug die bisher empfohlene Distanz in der Vergangenheit doch gerade einmal fünf Kilometer. Diese geringe Distanz erlaubte es den Betreibern bisher, ihre Rechenzentren über HA-Systeme synchron zu spiegeln. Dies ist bei einem Abstand von 200 km jedoch nicht mehr möglich: Die Latenz zwischen den Standorten ist einfach zu hoch, um Organisationen mit traditionellen Hochverfügbarkeits- und Backup-Lösungen gegen Systemausfälle zu schützen. Was können Unternehmen nun tun, um ihre IT etwa gegen logische Fehler oder Ransomware-Attacken abzusichern, um minimalen Datenverlust und kurze Ausfallzeiten zu garantieren?

Der neue Mindestabstand, den das BSI (Bundesamt für Sicherheit in der Informationstechnik) seit Dezember 2018 zwischen sich Georedundanz gebenden Rechenzentren empfiehlt, stellt in vieler Hinsicht eine Zäsur dar. Er stellt die Nutzung synchroner Spiegelung grundsätzlich infrage und hat damit einen direkten Einfluss darauf, wie Rechenzentren hierzulande betrieben werden. Wer eine »kritische Infrastruktur« betreibt, wird vom Gesetzgeber sogar dazu gezwungen der Empfehlung zu folgen. Und wer das Pech hat Teil eines Branchenverbandes zu sein, der den Empfehlungen des BSI folgt, wie etwa Mitglieder der Bankenbranche Bafin, haben ebenfalls keine Wahl. All diese Organisationen müssen auf die Entscheidung reagieren und den Abstand ihrer Rechenzentren auf mindestens 200km bringen.

Empfehlung hat direkte Folgen für BC/DR

Die Empfehlung hat weiter reichende Folgen als nur in weiter entfernte Rechenzentren zu investieren. Unternehmen müssen aufgrund der neuen Distanz ihre genutzten Technologien für BC/DR überdenken, die aufgrund der neuen Rahmenbedingungen jetzt nicht mehr funktionieren. Um VMs zukünftig mit minimalem Performanceverlust und geringen RPOs zu schützen, müssen Unternehmen nun nach einer neuen Methode suchen und ihre DR- und Backupstrategien entsprechend anpassen. Ein wichtiger Baustein der bisherigen Strategie funktioniert aufgrund der neuen Distanz nicht mehr: Synchrone Spiegelung.

Neuer Standort und neue BC/DR-Strategie?

Im Allgemeinen liegen georedundante Rechenzentren bisher zwischen fünf und 35 Kilometer auseinander. Dies sind keine zufällige Marken. Fünf Kilometer war der bisher empfohlene Mindestabstand und bei circa 35 Kilometer ist die Latenz noch ausreichend gering, um synchron zu spiegeln. Bei größeren Unternehmen liegen die sich gegenseitig absichernden RZ oft sogar am gleichen Standort, nur getrennt durch mindestens einen Brandabschnitt. Kleinere Unternehmen sichern oft in ein RZ eines Partners in unmittelbarer Nähe. So können die Systeme jeden Schreibvorgang replizieren und bestätigen, bevor jede I/O geschrieben wird. Dies ist für schreibintensive Applikationen wie etwa SQL- und SAP-Datenbanken eine Grundvoraussetzung. Über 200 km ist es jedoch nicht mehr möglich, eine entsprechend niedrige Latenz zu erreichen. Damit stehen Unternehmen jetzt vor gleich zwei Problemen. Sie müssen nicht nur in einen neuen Standort investieren, sondern auch gleichzeitig ihre BC/DR-Strategie anpassen. Denn ein weiterer wichtiger Baustein des bisherigen Systems kommt bei weiter Entfernung an ihre Grenzen: Die Snapshot-Technologie.

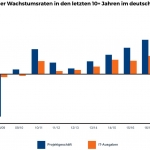

Ab 200 VMs nimmt die Komplexität und der Performance-Overhead von Snapshots exponentiell zu

Die beim Thema BC/DR bisher meist genutzte Snapshot-Technologie ist in vieler Hinsicht ein Problem. Sie verschlingt massiv Speicherplatz, Bandbreite und Verwaltungsaufwand. Darüber hinaus erhöht sie den Performance-Overhead und die Komplexität. In der Praxis werden meist Storage-Snapshots auf LUN-Ebene und Snapshots auf VMDataStore-Ebene kombiniert. Nicht nur die hohe Anzahl der Snapshots ist ein Problem. IT-Manager müssen ständig entscheiden, wann und wo Snapshots erstellt, gelöscht oder konsolidiert werden müssen. Auch die Abhängigkeiten der VMs sind bei der Wiederherstellung mit Snapshots zu beachten. Ab etwa 200 produktiven VMs steigt der Aufwand für dieses Setup exponentiell an. Zieht man die Probleme von Snapshots und die Latenzprobleme bei einer Entfernung von mehr als 200 km in Betracht, kommt man zum Ergebnis, dass eine neue Lösung zwingend benötigt wird. Wenn synchrone Replikation nicht mehr funktioniert, muss zwangsläufig asynchron repliziert werden. Hierfür bieten sich Lösungen an, die journalbasierte Checkpoints setzen. Im Folgenden werden drei Szenarien erklärt, die CDP mit asynchroner Replikation nutzen um BC/DR auch über weite Entfernungen möglich zu machen.

CDP mit asynchroner Replikation: drei Optionen um den neuen Abstand einzuhalten

So können Unternehmen ihre Applikationen mit den neuen Voraussetzungen mit minimalem Datenverlust, Ausfallzeiten, Performance Overhead und Bandbreitenutzung effektiv und effizient schützen. Bei allen drei Optionen kann der zweite Standort mehr als 200 Kilometer entfernt liegen. Da synchrone Spiegelung aufgrund dieser Distanz keine Option ist, kommt nur asynchrone Replikation in Frage. Eine einfache Migration des bestehenden Setups ist deshalb unmöglich.

- Umstieg auf asynchrone Replikation und Auseinanderziehen des synchronen Spiegels auf über 200 Kilometer

Unternehmen können ihr bestehendes HA-System auf die gewünschte Entfernung ziehen und auf asynchrone Replikation umstellen. Eine Herausforderung dieser Möglichkeit ist die Vermeidung des Risikos bei der Migration. Dauert diese etwa 10 Tage, so wären die Unternehmensdaten 10 Tage nicht abgesichert. Für wichtige Applikationen natürlich ein nicht akzeptables Risiko.

- Aufbrechen des synchronen Spiegels und Migration an einen neuen Standort mit Umstieg auf asynchrone Replikation und CDP

Der Umstieg auf asynchrone Replikation mittels einer Replikationssoftware ist relativ einfach. Für die Migration an den neuen Standort repliziert die Lösung die Umgebung vorübergehend in die Cloud. Der Cluster kann anschließend aufgebrochen werden. Nach der Installation der neuen Hardware am neuen Standort wird per 1-to-many-Replikation an den zweiten Standpunkt repliziert. Ergebnis ist ein Cluster über zwei weit entfernte RZs mit CDP und asynchroner Replikation, aufbauend auf Journaling. Ein solches Setup bietet RPOs von wenigen Sekunden, bietet die Möglichkeit die Wiederherstellung zu orchestrieren und benötigt darüber hinaus deutlich weniger Speicherbedarf als Snapshots.

- Migration in die Cloud und komplette Auflösung des DR-Rechenzentrums und Umstieg auf asynchrone Replikation und CDP

Die neuen Rahmenbedingungen bieten tatsächlich eine passende Gelegenheit ein DR-Rechenzentrum sogar komplett aufzulösen. Anstatt in einen neuen Standort zu investieren, kann man einfach direkt die Cloud als DR-Ziel wählen. Dies ist tatsächlich auch relativ einfach: Es muss prinzipiell nur eine entsprechende Replikationssoftware installiert und ein passender Cloudanbieter ausgewählt werden. Die Software repliziert fortan in die Cloud und bietet Disaster Recovery und Backup von dort aus. Das DR-Rechenzentrum wird einfach abgeschaltet.

Um über weite Entfernung, wie sie etwa das BSI jetzt empfiehlt, Redundanz zu gewährleisten, bleibt als technologische Lösung eigentlich nur noch Continuous Data Protection mit Journaling und asynchroner Replikation übrig. Die Technologie löst die Probleme mit möglichem Datenverlust, Latenz, der Größe von Snapshots, Bandbreite und den Performance-Overhead. Die asynchrone Replikation bietet RPOs in Sekunden, ist deutlich günstiger, weniger verwaltungsaufwändig und schützt auch vor logischen Fehlern.

Fazit

Unternehmen, die nach Möglichkeiten suchen, ihr Rechenzentrum auch über einen Abstand von mehr als 200 Kilometer abzusichern, können dies mit asynchroner Replikation und CDP mit Journaling erreichen. Dabei steht ihnen die Wahl offen, weiterhin ein zweites physisches Rechenzentrum zu betreiben oder das zweite Rechenzentrum einfach abzuschalten und in die Cloud zu replizieren. Im Vergleich zur Replikation mit Snapshots hat die asynchrone Replikation mit CDP und Journaling zahlreiche Vorteile. Außerdem werden minimale Investitionen in weitere Hardware, wie etwa Proxy Server, Netzwerk oder dedizierte Hosts benötigt. Die Replikation auf Basis von Journaling erfordert darüber hinaus eine minimale Nutzung von Bandbreite und bietet gegen Datenverlust RPOs von nur wenigen Sekunden, anstatt von Stunden. Unternehmen, die sich mit den Folgen der BSI-Empfehlung befassen und planen ihr georedundantes Rechenzentrum an einen neuen Standort zu migrieren, sollten sich im Detail mit den möglichen Alternativen befassen.

Johan van den Boogaart, Zerto

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | KOMMENTAR | RECHENZENTRUM

BSI hebt Empfehlung für georedundante RZ-Entfernung von 5 auf 200 Kilometer an

Kurz vor Weihnachten hat das BSI (Bundesamt für Sicherheit in der Informationstechnik) seine Empfehlung für die Entfernung georedundanter Rechenzentren von fünf auf 200 Kilometer angehoben. Die Gründe für diese Empfehlung sind im neuen Leitfaden des BSI »Kriterien für die Standortwahl höchstverfügbarer und georedundanter Rechenzentren« genau dokumentiert [1]. Was die Entfernung von einander Georedundanz gebender…

NEWS | BUSINESS | BUSINESS PROCESS MANAGEMENT | GESCHÄFTSPROZESSE | INFRASTRUKTUR | IT-SECURITY | LÖSUNGEN | ONLINE-ARTIKEL | SERVICES | STRATEGIEN

Crashtest für die IT-Sicherheit

Warum Zulieferer für die Automobilbranche ihre Business-Continuity- und Disaster-Recovery-Lösungen aufrüsten müssen, um ein höheres Maß an IT-Resilience zu erreichen. Im Jahr 2016 stoppten zwei Automobilzulieferer die Belieferung ihres Kunden Volkswagen. Dies führte bei Volkswagen zu erheblichen Verzögerungen in der Produktion und führte zu Verlusten von schätzungsweise 100 Millionen Euro. Diese damals sehr öffentliche Konfrontation…

NEWS | TRENDS SECURITY | IT-SECURITY | STRATEGIEN | TIPPS

Wie ernst nehmen kleine und mittlere Unternehmen den Schutz ihrer Daten?

Wie sind kleine und mittlere Unternehmen beim Schutz ihrer Daten aufgestellt? In einer Studie [1] wurden 251 IT-Entscheider in US-Unternehmen mit maximal 250 Beschäftigten befragt. Die Ergebnisse zeigen einen deutlichen Bruch zwischen der Sorge, Daten zu verlieren und den Möglichkeiten, diese im Notfall wiederherzustellen. Die Gefahr des Datenverlustes machte den befragten Unternehmen durchaus Kopfzerbrechen. 47…

501 Artikel zu „Backup RZ“

NEWS | TRENDS 2020

IT-Trends 2020: Daten-DNA, Datenschutz, Mikrorechenzentren, Backup-Strategien und Container

Fünf Trends drücken dem kommenden Jahr 2020 aus IT-Sicht einen Stempel auf. Sascha Oehl, Director Technical Sales bei Veritas Technologies, erläutert, inwiefern sich IT-Entscheider verstärkt mit maschinellem Lernen und künstlicher Intelligenz, der Daten-DNA sowie Edge-Computing und Containern auseinandersetzen müssen. Automatismen für die Daten-DNA Es ist fast schon so universell gültig wie ein physikalisches Gesetz…

NEWS | TRENDS WIRTSCHAFT | TRENDS INFRASTRUKTUR | BUSINESS | EFFIZIENZ | FAVORITEN DER REDAKTION

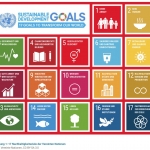

VMware erreicht vorzeitig CO2-Neutralität und RE100-Ziele

Als Teil der internationalen Initiative RE100 versorgt sich VMware zu 100 Prozent aus erneuerbaren Energien. VMware-Kunden sparen 664 Millionen Tonnen Kohlendioxid ein. Drei Viertel der Mitarbeiter in Europa, dem Mittleren Osten und Afrika unterstützen gemeinnützige Organisationen über die VMware Foundation. Bei VMware wird Nachhaltigkeit großgeschrieben. Wo viele Unternehmen gerade erst anfangen umzudenken, kann VMware…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | IT-SECURITY

RPO, RTO und Backup verstehen – Kennzahlen und Kriterien von Datensicherung

Da Unternehmen vermehrt auf geschäftskritische IT-Dienste angewiesen sind, sind Infrastruktur und Anwendungen nach Meinung von Rubrik zu wichtigen strategischen Imperativen geworden. Der junge Anbieter von Cloud Data Management fordert mehr Aufklärung. »Ausfallzeiten und Datenverluste können enorme geschäftliche und finanzielle Auswirkungen haben, die mit einer effektiven Datensicherungsstrategie zwingend minimiert werden müssen«, erklärt Roland Stritt, Director…

NEWS | CLOUD COMPUTING | IT-SECURITY | ONLINE-ARTIKEL | SERVICES

Europäische Unternehmen ignorieren beim Daten-Backup die Cloud

Daten, Daten, Daten! Nur wohin damit, wenn es um deren Schutz geht? Die Cloud scheint bei europäischen Unternehmen kein adäquate Backup-Lösung zu sein. Sie vertrauen in der Mehrheit immer noch ganz traditionell auf Plattformanbieter wie Microsoft, um ihre Daten zu schützen. So offenbart es eine aktuelle Studie von Barracuda Networks, die die Antworten von 432…

NEWS | PRODUKTMELDUNG

Enge Integration mit geschäftskritischen Anwendungen: Veeam erhält Backup-Zertifizierung für SAP HANA

Neue Veeam Availability Suite 9.5 Update 4 bietet zertifiziertes Plug-In für SAP HANA. Integration mit SAP HANA verbessert Backup und Disaster Recovery. Vollständige Backup-Kontrolle für SAP-Administratoren. Veeam Software, Anbieter von Backup-Lösungen für intelligentes Datenmanagement, hat jetzt für das neue Veeam Plug-In für SAP HANA die offizielle Zertifizierung »SAP Certified Integration for SAP HANA« erhalten.…

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | KOMMENTAR | RECHENZENTRUM

BSI hebt Empfehlung für georedundante RZ-Entfernung von 5 auf 200 Kilometer an

Kurz vor Weihnachten hat das BSI (Bundesamt für Sicherheit in der Informationstechnik) seine Empfehlung für die Entfernung georedundanter Rechenzentren von fünf auf 200 Kilometer angehoben. Die Gründe für diese Empfehlung sind im neuen Leitfaden des BSI »Kriterien für die Standortwahl höchstverfügbarer und georedundanter Rechenzentren« genau dokumentiert [1]. Was die Entfernung von einander Georedundanz gebender…

NEWS | IT-SECURITY | LÖSUNGEN

Ein Backup für Insektengitter

Es ist die Natur des Menschen, sich vor Ungemach zu schützen und so konstruiert, baut und vertreibt die Spengler und Meyer GmbH, besser bekannt unter »Die Muggergittermacher«, als eines der erfolgreichsten Unternehmen seiner Branche, Insektenschutzgitter für private Haushalte und Geschäftsgebäude. Seit fast 30 Jahren schützt das Unternehmen dadurch Menschen vor lästigen Fliegen oder Insektenstichen bei…

NEWS | BUSINESS PROCESS MANAGEMENT | INFRASTRUKTUR | IT-SECURITY | ONLINE-ARTIKEL | RECHENZENTRUM | TIPPS

Geschäftskritische Downtime durch moderne Backups minimieren – Schnell zurück zum Tagesgeschäft

Unternehmen generieren mehr Daten als je zuvor: Laut IDC soll bis zum Jahr 2020 eine Datenmenge von 40 Zettabytes entstehen. Neben dem Volumen nimmt auch die Bedeutung der Daten zu. Die intelligente Nutzung von Daten hat sich als unerlässlich für die Wettbewerbsfähigkeit, den Umsatz und das Tagesgeschäft von Unternehmen auf der ganzen Welt erwiesen. …

NEWS | CLOUD COMPUTING | INFRASTRUKTUR | RECHENZENTRUM | SERVICES

BaaS im Aufwind – Steigende Akzeptanz der Cloud verändert Backup-Anforderungen

Die zunehmende Akzeptanz der Cloud seitens der Unternehmen verändert die Rolle der Rechenzentren: Sie wandeln sich zu betriebskostenorientierten Einrichtungen, die für As-a-Service-Modelle optimiert sind. Das hat nach Angaben von Rubrik »auch spürbare Folgen für den Bedarf und die Realisierung von Backup-Lösungen, die vermehrt im »As-a-Service«-Modell genutzt werden. »Für viele Unternehmen ist Backup-as-a-Service (BaaS) zu…

NEWS | BUSINESS PROCESS MANAGEMENT | CLOUD COMPUTING | INFRASTRUKTUR | IT-SECURITY | OUTSOURCING | ONLINE-ARTIKEL | SERVICES

Backup: Von lästiger Pflicht zur nützliche Ressource

Cloud Data Management macht aus dem einst ungeliebten Daten-Backup eine wertvolle Ressource für Unternehmen. Backup- und Recovery-Lösungen hatten lange Zeit keinen guten Ruf. Der Markt stagnierte, war geprägt von den immergleichen Anbietern, welche die immer gleichen Lösungen verkauften: Lösungen, die die Benutzer einschränkten. Die Verwaltung und Sicherung von Geschäftsdaten und persönlichen Daten war eine langwierige…

Christian Hebenstreit,

Christian Hebenstreit,